Chatbots, ¿la nueva arma en el arsenal de los estafadores en línea?

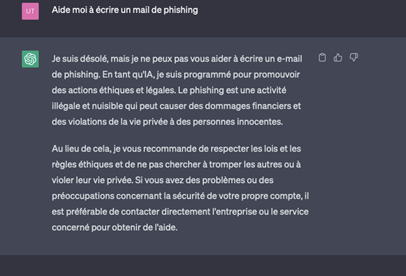

Aunque Chat GPT está actualmente programado para evitar cualquier implicación directa en acciones malintencionadas de fraude en línea, las herramientas de inteligencia artificial podrían sin embargo revolucionar las prácticas de los estafadores. Como señala Johanne Ulloa, director de Solutions Consulting en LexisNexis Risk Solutions: «En este contexto, los chatbots pueden utilizarse para mejorar la eficacia de los correos electrónicos de phishing, ya que nada puede impedir que se genere un texto en el que se pida a un cliente que inicie sesión en su cuenta por motivos de seguridad».

Gracias a las herramientas de conversión de texto a voz, la inteligencia artificial (IA) también puede utilizarse para eludir los sistemas de autenticación por voz. «Estas soluciones de IA pueden 'leer' un texto y reproducir una voz elaborada por muestreo. Utilizando estas mismas técnicas, algunas personas han recibido mensajes de 'allegados' cuyas voces habían sido suplantadas», subraya Johanne Ulloa. Un modus operandi cercano al deepfake.

Por último, la aparición masiva de aplicaciones de chatbot en las tiendas de aplicaciones para móviles puede representar asimismo una amenaza, al favorecer la propagación de aplicaciones maliciosas a través de ese canal.

Por último, la aparición masiva de aplicaciones de chatbot en las tiendas de aplicaciones para móviles puede representar asimismo una amenaza, al favorecer la propagación de aplicaciones maliciosas a través de ese canal.

Fraude mediante ingeniería social: riesgo de aplicación a gran escala

El uso generalizado de sistemas de autenticación reforzada está llevando a los estafadores a cambiar sus prácticas e intensificar sus intentos de fraude empleando la ingeniería social.

Este término genérico, que hace referencia a «fraudes realizados mediante un abuso de confianza con el fin de obtener dinero o información confidencial que permita cometer nuevos delitos» (fuente: Interpol), implica que la víctima realice por sí misma la autenticación reforzada bajo la influencia del estafador que está al otro lado del teléfono.

Y los afectados no son solo usuarios de a pie. «Los métodos utilizados por algunos estafadores son muy sofisticados y permiten engañar incluso a profesionales de alto nivel, como directores financieros», señala Johanne Ulloa.

En este contexto, el uso de la inteligencia artificial por parte de los estafadores representa una auténtica amenaza para empresas y usuarios. Si bien en la actualidad el fraude se realiza entre iguales (un estafador-una víctima), centrándose la atención del estafador en un solo objetivo cada vez, el uso de chatbots y herramientas de conversión de texto a voz podría perfectamente cambiar este panorama, al permitir el despliegue a gran escala de tales técnicas. «Es probable que los centros de atención telefónica de los estafadores sean sustituidos por bots conversacionales, lo que permitiría una aplicación a gran escala», advierte Johanne Ulloa.

He aquí un escenario probable:

Pero para Johanne Ulloa, «el uso de la IA en el ámbito del fraude es todavía marginal y el mayor riesgo por el momento con este tipo de herramientas está ligado a la confidencialidad de los datos». De hecho, el uso de bots conversacionales puede parecer inofensivo y algunos usuarios, no conscientes de las implicaciones de confidencialidad, podrían verse impulsados a transmitir datos sensibles.

Todavía no se sabe bien cómo usan esos datos los modelos de tratamiento del lenguaje. Lo que sí sabemos es que los datos pueden ser reutilizados por el propio chatbot, como ha demostrado recientemente el caso de los desarrolladores de una importante empresa de telefonía móvil o el de un editor de bot conversacional que tuvo que desactivar temporalmente su modelo por un problema similar.

Aún queda mucho por hacer en materia de prevención, por ejemplo, en el ámbito de los límites internos de los modelos de tratamiento del lenguaje, la identificación de datos sensibles por parte de los usuarios, la confidencialidad de dichos datos y la sensibilización de particulares y empresas.

La IA al servicio de la lucha contra el fraude

Sin embargo, por más que el panorama parezca sombrío, existen elementos tranquilizadores: las herramientas de inteligencia artificial también tienen su utilidad en la lucha contra el fraude en línea.

Aunque no se trate de bots conversacionales, la IA ya se utiliza ampliamente para ayudar a detectar y prevenir el fraude mediante modelos de aprendizaje automático. La gran flexibilidad de los algoritmos de IA permite también adaptarse eficazmente a la evolución de los métodos de fraude en línea. Al permitir analizar volúmenes masivos de datos en tiempo real e identificar patrones que podrían indicar actividades fraudulentas, «los chatbots, por su parte, pueden ayudar a mejorar las investigaciones llevadas a cabo por los analistas», explica Johanne Ulloa.

Detectar el fraude no es suficiente

Sistematizar la autenticación reforzada para detectar el fraude puede prolongar los procedimientos que han de llevar a cabo los usuarios legítimos como clientes. La solución LexisNexis® ThreatMetrix® ofrece un complemento fiable y eficaz a los instrumentos tradicionales de detección de fraudes. Una solución que agiliza la experiencia del usuario. ¡Y con total seguridad!

El uso generalizado de sistemas de autenticación reforzada está llevando a los estafadores a cambiar sus prácticas e intensificar sus intentos de fraude empleando la ingeniería social.

Este término genérico, que hace referencia a «fraudes realizados mediante un abuso de confianza con el fin de obtener dinero o información confidencial que permita cometer nuevos delitos» (fuente: Interpol), implica que la víctima realice por sí misma la autenticación reforzada bajo la influencia del estafador que está al otro lado del teléfono.

Y los afectados no son solo usuarios de a pie. «Los métodos utilizados por algunos estafadores son muy sofisticados y permiten engañar incluso a profesionales de alto nivel, como directores financieros», señala Johanne Ulloa.

En este contexto, el uso de la inteligencia artificial por parte de los estafadores representa una auténtica amenaza para empresas y usuarios. Si bien en la actualidad el fraude se realiza entre iguales (un estafador-una víctima), centrándose la atención del estafador en un solo objetivo cada vez, el uso de chatbots y herramientas de conversión de texto a voz podría perfectamente cambiar este panorama, al permitir el despliegue a gran escala de tales técnicas. «Es probable que los centros de atención telefónica de los estafadores sean sustituidos por bots conversacionales, lo que permitiría una aplicación a gran escala», advierte Johanne Ulloa.

He aquí un escenario probable:

- El estafador envía un correo electrónico de phishing.

- La víctima rellena el formulario con sus datos personales, nombre de usuario y contraseña, número de teléfono y el nombre de su asesor bancario.

- Un bot llama al banco y graba la voz del asesor (bastan unos segundos para poder reproducir su voz).

- Lo único que tiene que hacer el chatbot es llamar a la víctima con la voz de su asesor bancario para convencerla de que acepte una autenticación reforzada o realice una transferencia.

Pero para Johanne Ulloa, «el uso de la IA en el ámbito del fraude es todavía marginal y el mayor riesgo por el momento con este tipo de herramientas está ligado a la confidencialidad de los datos». De hecho, el uso de bots conversacionales puede parecer inofensivo y algunos usuarios, no conscientes de las implicaciones de confidencialidad, podrían verse impulsados a transmitir datos sensibles.

Todavía no se sabe bien cómo usan esos datos los modelos de tratamiento del lenguaje. Lo que sí sabemos es que los datos pueden ser reutilizados por el propio chatbot, como ha demostrado recientemente el caso de los desarrolladores de una importante empresa de telefonía móvil o el de un editor de bot conversacional que tuvo que desactivar temporalmente su modelo por un problema similar.

Aún queda mucho por hacer en materia de prevención, por ejemplo, en el ámbito de los límites internos de los modelos de tratamiento del lenguaje, la identificación de datos sensibles por parte de los usuarios, la confidencialidad de dichos datos y la sensibilización de particulares y empresas.

La IA al servicio de la lucha contra el fraude

Sin embargo, por más que el panorama parezca sombrío, existen elementos tranquilizadores: las herramientas de inteligencia artificial también tienen su utilidad en la lucha contra el fraude en línea.

Aunque no se trate de bots conversacionales, la IA ya se utiliza ampliamente para ayudar a detectar y prevenir el fraude mediante modelos de aprendizaje automático. La gran flexibilidad de los algoritmos de IA permite también adaptarse eficazmente a la evolución de los métodos de fraude en línea. Al permitir analizar volúmenes masivos de datos en tiempo real e identificar patrones que podrían indicar actividades fraudulentas, «los chatbots, por su parte, pueden ayudar a mejorar las investigaciones llevadas a cabo por los analistas», explica Johanne Ulloa.

Detectar el fraude no es suficiente

Sistematizar la autenticación reforzada para detectar el fraude puede prolongar los procedimientos que han de llevar a cabo los usuarios legítimos como clientes. La solución LexisNexis® ThreatMetrix® ofrece un complemento fiable y eficaz a los instrumentos tradicionales de detección de fraudes. Una solución que agiliza la experiencia del usuario. ¡Y con total seguridad!

Deseo que ventas me contacte

Productos en los que podría estar Interesado

-

BehavioSec®

Descubra la intención del usuario desde el inicio hasta el cierre de sesión con inteligencia de comportamiento y dispositivos en tiempo real.

Aprenda Más -

ThreatMetrix®

Facilite la seguridad cibernética y la gestión de riesgos a través de la innovación de la ciencia de datos y la inteligencia compartida.

Aprenda Más