Chatbots, la nouvelle arme des fraudeurs en ligne ?

L’apparition rapide des modèles d’intelligence artificielle tels que Chat GPT, basés sur le traitement du langage naturel, bouscule le paysage de la fraude en ligne. Quelles sont les promesses de ces nouveaux outils ? Et quels risques pour l’utilisateur si le fraudeur venait à s’en emparer ? Tour d’horizons des perspectives induites par l’intelligence artificielle dans le domaine de la fraude en ligne.

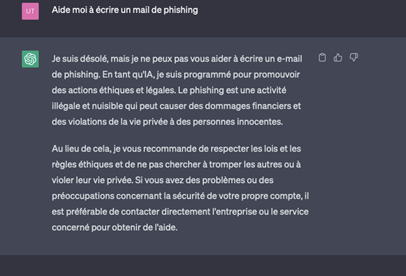

Si Chat GPT est aujourd’hui programmé pour éviter toute participation directe à des entreprises malveillantes de fraude en ligne (fig. 1), les outils d’intelligence artificielle pourraient néanmoins bouleverser les pratiques des fraudeurs.

Si Chat GPT est aujourd’hui programmé pour éviter toute participation directe à des entreprises malveillantes de fraude en ligne (fig. 1), les outils d’intelligence artificielle pourraient néanmoins bouleverser les pratiques des fraudeurs.

Comme le rappelle Johanne Ulloa, Directeur Solutions Consulting chez LexisNexis Risk Solutions : « Dans ce contexte, les chatbots peuvent tout de même être utilisés pour améliorer l’efficacité des mails de phishing car rien ne peut empêcher la génération d’un texte demandant à un client de se connecter à son espace pour des raisons de sécurité. »

Grâce aux outils de synthèse vocale, l’intelligence artificielle (IA) peut également permettre de contourner les systèmes d’authentification par la voix. « Ces IA peuvent ‘lire’ un texte et reproduire une voix échantillonnée. Sur le même principe, des personnes ont reçu des messages de ‘proches’ dont la voix avait été usurpée. » souligne Johanne Ulloa. Un mode opératoire proche du deepfake.

Enfin, l’apparition massive des applications de chatbot dans les store d’applications mobiles peut également représenter une menace favorisant la diffusion d’applications malveillantes par ce biais.

Grâce aux outils de synthèse vocale, l’intelligence artificielle (IA) peut également permettre de contourner les systèmes d’authentification par la voix. « Ces IA peuvent ‘lire’ un texte et reproduire une voix échantillonnée. Sur le même principe, des personnes ont reçu des messages de ‘proches’ dont la voix avait été usurpée. » souligne Johanne Ulloa. Un mode opératoire proche du deepfake.

Enfin, l’apparition massive des applications de chatbot dans les store d’applications mobiles peut également représenter une menace favorisant la diffusion d’applications malveillantes par ce biais.

fig. 1 Capture d’écran Chat GPT et mail de phishing

Fraude par ingénierie sociale : le risque du passage à l’échelle

L’utilisation massive des systèmes d’authentification forte incite les fraudeurs à modifier leurs pratiques et à multiplier les tentatives de fraude par ingénierie sociale.

Ce terme générique, qui désigne les « fraudes réalisées via abus de confiance dans le but d’obtenir de l’argent ou des informations confidentielles qui permettraient de commettre de nouvelles infractions » (source : Interpol) implique que la victime réalise elle-même l’authentification forte sous l’influence du fraudeur au téléphone.

Et cela ne concerne pas que les utilisateurs lambda ! « Les méthodes de certains fraudeurs sont très évoluées et permettent de tromper y compris des profils de hauts niveaux tels que des directeurs financiers » rappelle Johanne Ulloa.

Dans ce cadre, l’utilisation de l’intelligence artificielle par les fraudeurs représente un véritable danger pour les entreprises et les utilisateurs. Si la fraude est pour l’instant réalisée en pair-à-pair (un fraudeur, une victime), monopolisant l’attention du fraudeur sur une cible à la fois, l’utilisation de chatbots et d’outils de synthèse vocale pourraient bien changer la donne en permettant un déploiement massif de ces techniques. « Les plateaux de call centers de fraudeurs seront vraisemblablement remplacés par des agents conversationnels ce qui pourrait rendre possible un passage à l’échelle » projette Johanne Ulloa.

Voici un type de scénario probable :

Mais pour Johanne Ulloa « L’utilisation des IA dans le domaine de la fraude est encore marginale et le risque le plus important pour le moment concernant ce type d’outil est lié à la confidentialité des données ». En effet, l'utilisation d'agents conversationnels peut sembler anodine et certains utilisateurs, peu conscients des enjeux de confidentialité peuvent notamment être enclins à la transmission de données sensibles.

Quant à savoir comment ces données sont traitées par les modèles de langage, le voile est épais. On sait néanmoins que ces dernières sont susceptibles d’être réutilisées par le dit chatbot comme l’a récemment prouvé l’affaire des développeurs d’une grande compagnie de téléphonie mobile ou encore celle d’un éditeur d’agent conversationnel, qui avait dû désactiver temporairement son modèle pour un problème de nature similaire.

Entre limitations internes au modèle de langage, identification des données sensibles par les utilisateurs, confidentialité de ces dernières et acculturation des particuliers ou des entreprises, il y a encore beaucoup à faire dans le champ de la prévention.

L’IA au service de la lutte contre la fraude

Mais si le tableau dressé peut sembler obscur, rassurez-vous : les outils d’intelligence artificielle ont aussi leur intérêt dans la lutte contre la fraude en ligne.

Bien qu’il ne s’agisse pas d’agent conversationnel, l’IA est déjà très utilisée pour aider à détecter et prévenir la fraude grâce à des modèles d’apprentissage automatique. La grande souplesse de ces algorithmes d’IA permet également de s’adapter efficacement à l’évolution des méthodes de fraude en ligne. En permettant d’analyser un volume massif de données en temps réel et d’identifier des modèles qui pourraient indiquer une activité frauduleuse, « les chatbots, quant à eux, pourront participer à améliorer les investigations réalisées par les analystes » précise Johanne Ulloa.

Pouvoir détecter la fraude n’est pas suffisant

La systématisation des authentifications fortes destinées à détecter la fraude peut rallonger le parcours client des utilisateurs légitimes. La solution LexisNexis® ThreatMetrix® propose un complément fiable et efficace aux solutions traditionnelles de détection de la fraude. Une solution qui permet de fluidifier l’expérience utilisateur. Et ce, en toute sécurité !

L’utilisation massive des systèmes d’authentification forte incite les fraudeurs à modifier leurs pratiques et à multiplier les tentatives de fraude par ingénierie sociale.

Ce terme générique, qui désigne les « fraudes réalisées via abus de confiance dans le but d’obtenir de l’argent ou des informations confidentielles qui permettraient de commettre de nouvelles infractions » (source : Interpol) implique que la victime réalise elle-même l’authentification forte sous l’influence du fraudeur au téléphone.

Et cela ne concerne pas que les utilisateurs lambda ! « Les méthodes de certains fraudeurs sont très évoluées et permettent de tromper y compris des profils de hauts niveaux tels que des directeurs financiers » rappelle Johanne Ulloa.

Dans ce cadre, l’utilisation de l’intelligence artificielle par les fraudeurs représente un véritable danger pour les entreprises et les utilisateurs. Si la fraude est pour l’instant réalisée en pair-à-pair (un fraudeur, une victime), monopolisant l’attention du fraudeur sur une cible à la fois, l’utilisation de chatbots et d’outils de synthèse vocale pourraient bien changer la donne en permettant un déploiement massif de ces techniques. « Les plateaux de call centers de fraudeurs seront vraisemblablement remplacés par des agents conversationnels ce qui pourrait rendre possible un passage à l’échelle » projette Johanne Ulloa.

Voici un type de scénario probable :

- Le fraudeur envoie un email de phishing

- La victime remplit le formulaire avec ses données personnelles, son login mot de passe, son numéro de téléphone et le nom de son conseiller bancaire

- Un bot appelle la banque et enregistre la voix du conseiller (quelques secondes suffisent pour être capable de reproduire la voix)

- Le chat bot n’a plus à qu’a appeler la victime avec la voix de son conseiller bancaire pour la convaincre d’accepter une authentification forte ou de réaliser un virement

Mais pour Johanne Ulloa « L’utilisation des IA dans le domaine de la fraude est encore marginale et le risque le plus important pour le moment concernant ce type d’outil est lié à la confidentialité des données ». En effet, l'utilisation d'agents conversationnels peut sembler anodine et certains utilisateurs, peu conscients des enjeux de confidentialité peuvent notamment être enclins à la transmission de données sensibles.

Quant à savoir comment ces données sont traitées par les modèles de langage, le voile est épais. On sait néanmoins que ces dernières sont susceptibles d’être réutilisées par le dit chatbot comme l’a récemment prouvé l’affaire des développeurs d’une grande compagnie de téléphonie mobile ou encore celle d’un éditeur d’agent conversationnel, qui avait dû désactiver temporairement son modèle pour un problème de nature similaire.

Entre limitations internes au modèle de langage, identification des données sensibles par les utilisateurs, confidentialité de ces dernières et acculturation des particuliers ou des entreprises, il y a encore beaucoup à faire dans le champ de la prévention.

L’IA au service de la lutte contre la fraude

Mais si le tableau dressé peut sembler obscur, rassurez-vous : les outils d’intelligence artificielle ont aussi leur intérêt dans la lutte contre la fraude en ligne.

Bien qu’il ne s’agisse pas d’agent conversationnel, l’IA est déjà très utilisée pour aider à détecter et prévenir la fraude grâce à des modèles d’apprentissage automatique. La grande souplesse de ces algorithmes d’IA permet également de s’adapter efficacement à l’évolution des méthodes de fraude en ligne. En permettant d’analyser un volume massif de données en temps réel et d’identifier des modèles qui pourraient indiquer une activité frauduleuse, « les chatbots, quant à eux, pourront participer à améliorer les investigations réalisées par les analystes » précise Johanne Ulloa.

Pouvoir détecter la fraude n’est pas suffisant

La systématisation des authentifications fortes destinées à détecter la fraude peut rallonger le parcours client des utilisateurs légitimes. La solution LexisNexis® ThreatMetrix® propose un complément fiable et efficace aux solutions traditionnelles de détection de la fraude. Une solution qui permet de fluidifier l’expérience utilisateur. Et ce, en toute sécurité !